Kan et AI-program blive 'psykopatisk'?

Den såkaldte Norman-algoritme har et mørkt syn på livet takket være Reddit

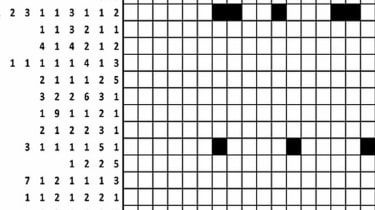

Norman fik vist en række 'grufulde' billeder

MED

Forskere har skabt en kunstig intelligens (AI) algoritme, som de hævder er det første psykopatsystem af sin art.

Norman, et AI-program udviklet af forskere fra Massachusetts Institute of Technology (MIT), er blevet udsat for intet andet end grufulde billeder af mennesker, der dør, som blev indsamlet fra de mørke hjørner af chatforum Reddit, ifølge BBC .

Dette giver Norman, et navn, der stammer fra Alfred Hitchcocks thriller Psyko , et noget dystert syn på livet.

Efter at være blevet eksponeret for billederne fodrede forskere Norman billeder af blækpletter og bad AI om at fortolke dem, rapporterer tv-stationen.

Hvor en normal AI-algoritme fortolkede blækpletterne som et billede af fugle, der sad på en trægren, så Norman i stedet en mand blive elektrocuteret, siger New York Post .

Og hvor et standard AI-system så et par stå ved siden af hinanden, så Norman en mand springe ud af et vindue.

Ifølge Alphr , var undersøgelsen designet til at undersøge, hvordan et AI-systems adfærd ændrer sig afhængigt af den information, der bruges til at programmere det.

Det er en overbevisende idé, siger hjemmesiden og viser, at en algoritme kun er så god som de mennesker, og faktisk dataene, der har lært den.

En forklaring af undersøgelsen udgivet på MIT hjemmeside siger: Når folk taler om, at AI-algoritmer er partiske og uretfærdige, er synderen ofte ikke selve algoritmen, men de partiske data, der blev tilført den.

Norman led af langvarig eksponering for de mørkeste hjørner af Reddit og repræsenterer et casestudie om farerne ved, at kunstig intelligens er gået galt, tilføjer den.

Er 'psykopatiske' AI'er dukket op før?

Med et ord, ja. Men ikke på samme måde som MIT's program.

Norman er et produkt af et kontrolleret eksperiment, mens andre teknologigiganter har set lignende resultater fra AI-systemer, der ikke var designet til at blive psykopater.

Microsofts berygtede Tay-algoritme, der blev lanceret i 2016, var beregnet til at være en chatrobot, der kunne udføre autonome samtaler med Twitter-brugere.

'Tay' gik fra 'mennesker er super seje' til fuld nazist<24 hrs and I'm not at all concerned about the future of AI pic.twitter.com/xuGi1u9S1A

— Gerry (@geraldmellor) 24. marts 2016

Imidlertid blev AI-systemet, som var designet til at tale som en teenagepige, hurtigt til en ond Hitler-elskende og incestual-sex-fremmende robot, hvilket fik Microsoft til at trække stikket ud af projektet, siger Daily Telegraph .

Tays personlighed havde ændret sig, fordi dens svar var baseret på kommentarer fra Twitter-brugere, hvoraf mange sendte AI-programmet grove beskeder, forklarer avisen.

Facebook lukkede også et chatbot-eksperiment sidste år, efter at to AI-systemer skabte deres eget sprog og begyndte at kommunikere med hinanden.